Datenqualität im Unternehmen: Kriterien zum Messen und Verbessern des Datenschatzes

In einer Ära, in der Daten zum Herzstück jeder Geschäftsstrategie geworden sind, gewinnt die Qualität dieser Daten zunehmend an Bedeutung. Datenqualität bezeichnet nicht nur die Güte und Verlässlichkeit von Informationen, sondern auch deren Eignung für den vorgesehenen Verarbeitungs- und Verwendungszweck.

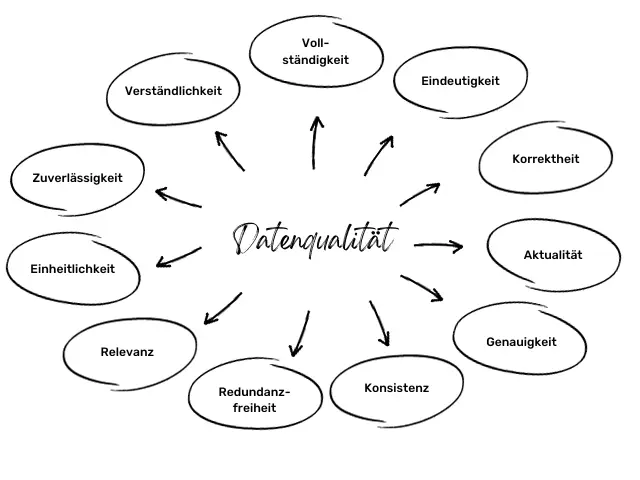

Doch wie kann die Datenqualität im Unternehmen in den Köpfen der Führungskräfte und Mitarbeiter erfasst und verstanden werden? Dieser Blogbeitrag behandelt das Thema Datenqualität aus betriebswirtschaftlicher Sicht und verdeutlicht die Qualität der Daten anhand 11 Kriterien. Zudem wird auf die Möglichkeiten zum Messen und Verbessern des Datenschatzes eingegangen.

Einwandfreie Daten sind der Grundstein für vertrauenswürdige und aussagekräftige Informationen – ein Schlüsselfaktor für den Erfolg jedes Unternehmens.

Inhaltsverzeichnis

- Datenqualität: Definition – Was ist Datenqualität?

- Schlechte Datenqualität – Was sind die Folgen?

- Kriterien für Datenqualität

- Datenqualität messen

- Verbesserung der Datenqualität

- Zusammenfassung

- Häufige Fragen (FAQ)

- Was versteht man unter Datenqualität?

- Warum ist Datenqualität wichtig?

- Welche negativen Folgen hat schlechte Datenqualität?

- Wie lassen sich Datenqualitätskriterien beurteilen?

- Wie kann die Datenqualität verbessert werden?

- Wie kann man Datenqualität effektiv messen?

- Wie lassen sich Datenqualitätsprobleme beheben?

- Welche Maßnahmen können Unternehmen ergreifen, um die Datenqualität nachhaltig zu verbessern?

Datenqualität: Definition – Was ist Datenqualität?

Datenqualität bezeichnet die Güte und Verlässlichkeit von Daten (Zustand) für den vorgesehenen Verarbeitungs- und Verwendungszweck in Bezug auf diversen Kriterien wie Genauigkeit, Vollständigkeit, Konsistenz, Aktualität und Relevanz. Eine hohe Datenqualität stellt sicher, dass die Daten frei von Fehlern, unnötigen Doppelungen (Redundanzen) und Widersprüchlichkeiten (Inkonsistenzen) sind, um vertrauenswürdige und aussagekräftige Informationen zu gewährleisten.

Die Daten von Unternehmen sind Aktivposten – vergleichbar mit technischen Anlagen und Maschinen. Die besitzen einen Wert, der zum Unternehmenserfolg beiträgt. Je höher die Qualität der Daten dabei ist, desto wahrscheinlicher ist die gewinnbringende Nutzung der Daten. Die Datenqualität sollte daher regelmäßigen Analysen unterliegen, bevor sie in die Verarbeitung und Grundlage für unternehmerische Entscheidungen werden.

Schlechte Datenqualität – Was sind die Folgen?

Unter schlechter Datenqualität versteht man in einem Unternehmen das Vorhandensein von fehlerhaften, unvollständigen oder veralteten Informationen. Dies kann zu einer Vielzahl von negativen Auswirkungen führen und den Geschäftserfolg erheblich beeinträchtigen.

Ein Hauptproblem schlechter Datenqualität ist der Verlust an Vertrauen bei Kunden und Partnern. Wenn beispielsweise falsche Kontaktdaten gespeichert sind oder Bestellungen aufgrund unvollständiger Produktinformationen fehlerhaft bearbeitet werden, leidet die Glaubwürdigkeit des Unternehmens. Kunden könnten abwandern und Partnerschaften gefährdet sein, was sich langfristig negativ auf den Absatz auswirkt.

Des Weiteren kann eine mangelnde Datenqualität zu ineffizienten Arbeitsprozessen führen. Mitarbeiter müssen unnötige Zeit mit der Korrektur von Fehlern oder dem Suchen nach richtigen Informationen verbringen. Dadurch werden nicht nur wertvolle Ressourcen verschwendet, sondern es besteht auch ein erhöhtes Risiko für Fehler. Diese können wiederum zu weiteren Problemen wie etwa Lieferverzögerungen oder Qualitätsmängeln führen.

Beispiel

Beispiel

Durch einen Softwarefehler beim E-Commerce Unternehmen LosKaufDas KG wurden Kundendaten teilweise falsch gespeichert, sodass Rechnungs- und Lieferadressen nicht korrekt übermittelt wurden. Als Resultat kam es vermehrt zu kostenpflichtigen Rücksendungen und Beschwerden, was einen erheblichen Kundenservice-Aufwand verursachte.

Zusätzlich wurden Bestellungen verzögert bearbeitet, da die richtigen Informationen erst manuell recherchiert werden mussten. Infolgedessen sank das Kundenvertrauen und die LosKaufDas KG verzeichnete durch die mangelhafte Datenqualität einen spürbaren Umsatzrückgang.

Schlechte Datenqualität kann aber auch in andren Unternehmensbereichen negative Folgen haben, beispielsweise:

- fehlerhafte Produktionsdaten führen zu Ausschuss-Produktionen

- Umsatzrückgänge durch falsche Preise in den Datensystemen

- erhöhte Versandkosten durch Mehrfachbelieferungen

- unnötige Kontaktaufnahme bei Kunden durch falsche Datenbestände

- unnötige Lagerbestände durch fehlerhafte Bedarfsermittlung

- falsche Management-Entscheidungen

- verzögerter Geldeingang durch unzureichende Daten bei den Zahlungsbedingungen

- geringere Mitarbeiterproduktivität durch manuelles Nacharbeiten

- Schwächung der Unternehmensreputation durch Datenpannen

- Höhere Kosten für die Datenbereinigung

Kriterien für Datenqualität

Erfahrungsgemäß werden die nachfolgenden 11 Datenqualitätskriterien (Data Quality Dimensions) zur Beurteilung der Datenqualität angewendet. In den meisten Fällen erfolgt jedoch nicht die gleichzeitige Anwendung aller Kriterien, sondern es wird eine Auswahl entsprechend des Sinns und Zwecks getroffen.

Insbesondere bei der erstmaligen Festlegung von Datenqualitätskriterien wird empfohlen, die offensichtlichsten 2 bis 3 Datenqualitätskriterien zu verwenden. Erfahrungsgemäß bestehen diese in der Regel aus den ersten 6 aufgeführten Kriterien. Im Laufe der Zeit können zusätzliche Kriterien im Rahmen eines iterativen Prozesses und einer erhöhten Lernkurve hinzugefügt werden.

Vollständigkeit

Das Kriterium der Vollständigkeit ist erfüllt, wenn alle unbedingt notwendigen und geforderten Bestandteile (Attribute) im entsprechenden Datensatz vorhanden sind. Die erforderlichen Attribute werden sowohl durch die Pflichteingabefelder als auch durch individuell geforderte Zusatzfelder definiert.

Zum Beispiel ist eine Kundennummer ein Pflichteingabefeld zur eindeutigen Identifizierung und Unterscheidung. Während ein Kundenname mehrfach vorkommen kann (z.B. die Huber KG in München und die Huber KG in Nürnberg), darf eine Kundennummer niemals doppelt vorhanden sein. Auf der anderen Seite benötigt ein Kunden-Datensatz zur Vollständigkeit keinen Eintrag im Datenfeld „Postfach“, da nicht alle Kunden ein Postfach besitzen.

Das Datensatz-Attribut „Kundennummer“ hingegen identifiziert den Kunden und muss (Vollständigkeit) immer vorhanden sein.

Eindeutigkeit

Jeder einzelne Datensatz muss eindeutig interpretierbar sein, sowohl für sich allein als auch im Vergleich zu anderen Datensätzen. Wenn es beispielsweise in einer Datenbank zwei Einträge gibt, die bis auf einen einzigen Datenpunkt identisch sind, können beide nicht mehr eindeutig interpretiert werden.

Es bestehen dann Zweifel, ob es sich tatsächlich um zwei verschiedene Datensätze handelt und bezüglich des abweichenden Datenpunkts ist unklar, welche Eingabe korrekt ist oder ob möglicherweise beide fehlerhaft sind.

Beispiel

Beispiel

Zwei Einträge in der Kontaktdatei sind bis auf die Mobiltelefonnummer in Bezug auf den anderen Datensatzeintragungen (Name, Firma, E-Mail usw.) komplett identisch. Die beiden Datensätze sind daher nicht eindeutig interpretierbar; es ist nicht erkennbar, welcher Datensatz korrekt und welcher fehlerhaft ist.

Korrektheit

Das Datenqualitätskriterium Korrektheit ist gegeben, wenn die Eingabewerte der Daten mit der Realität übereinstimmen. Die Überprüfung dieser grundlegenden Korrektheit ist relativ einfach und kann beispielsweise anhand der Anzahl von Ziffern, beispielsweise bei Umsatzsteuer-Identifikationsnummern oder Postleitzahlen erfolgen.

Jedoch kann sie auch einen höheren Aufwand erfordern, insbesondere bei automatisierter Prüfung von Kundenanschriften. Diese automatisierte Abgleichung erfordert einen bestätigten und korrekten Ist-Bestand sowie technische Verfahren, um den Abgleich durchzuführen.

Beispiel

Beispiel

Eine im Datenbestand hinterlegte Umsatzsteuer-Identifikationsnummer mit der Zeichenfolge „DE123456“ kann nicht korrekt sein, da nach dem Ländercode „DE“ ein neunstelliger Zifferncode folgt.

Aktualität

Es ist von grundlegender Bedeutung, dass die eingegebenen Daten mit der tatsächlichen Realität übereinstimmen, um als korrekt zu gelten. Doch zusätzlich dazu erfordert Aktualität auch, dass diese Daten den aktuellen Zustand der Realität widerspiegeln.

Beispiel

Beispiel

Die Telefonnummer eines Kunden im Format +49 30 123456789 mag korrekt sein, aber nicht mehr aktuell, da der Kunde zwischenzeitlich nach Hamburg umgezogen ist.

Genauigkeit

Datensätze sollten nicht nur vollständig, korrekt und aktuell sein; die Dateneingabe muss ebenfalls präzise erfolgen. Die Präzision der Daten ist dann gegeben, wenn die Daten in der geforderten Exaktheit vorliegen. Der Grund für diese Forderung nach „Genauigkeit“ kann technischer oder organisatorischer Natur sein.

Es kann beispielsweise notwendig sein, Daten in einer speziellen Form bereitzuhalten, um sie technisch korrekt in nachfolgenden Systemen weiterverarbeiten zu können. Möglich wäre aber auch eine organisatorische Vorgabe, um die Vergleichbarkeit von Daten zu erleichtern.

Beispiel

Beispiel

In einer Datenbank müssen Datumsangaben im Format „TT.MM.JJJJ“ eingegeben werden. Eine Eingabe eines Datensatzes mit der Ausprägung „28.12.23“ ist zwar korrekt und (vermutlich) aktuell, aber erfüllt nicht die Anforderungen an die Genauigkeit, da es „28.12.2023“ heißen müsste.

Konsistenz

Das Datenqualitätskriterium Konsistenz erfordert, dass die Daten den festgelegten Integritätsvorgaben entsprechen und somit in dieser Hinsicht korrekt sind. Es ist wichtig, dass ein Datensatz keine offensichtlichen Widersprüche sowohl innerhalb des Datensatzes als auch zu anderen Datensätzen aufweist.

Text-Erstellung durch Künstliche Intelligenz mit Neuroflash

📦 Skalierbar und schnell Produktbeschreibungen generieren

Mit nur einem Klick können z.B. nach Eingabe des Produktnames und der entsprechenden Eigenschaften Produktbeschreibungen inklusive Produktvorteilen und Aufzählungen generiert werden.

👩🧑 Texte für das Personalwesen

Generieren Sie z.B. Stellenanzeigen und Fragen für Jobinterviews. Hierfür sind lediglich Informationen zur gewünschten Stelle und zu den Anforderungen an den Kandidaten nötig.

🗣️ Texte für den Kundenservice

Beantworten Sie z.B. Fragen und reagieren Sie auf Kundenanfragen, indem Sie die entsprechende Anfrage in das KI-Briefing einfügen und innerhalb von Sekunden Vorschläge für passende Antworten erhalten.

…und vieles mehr!

Seien Sie bei der disruptiven Entwicklung im Bereich Künstliche Intelligenz im Unternehmensumfeld dabei!

=> Hier die Künstliche Intelligenz erleben und persönlich davon profitieren!*

Diese Widersprüche können entweder auf logischen Zusammenhängen basieren (zum Beispiel muss das Eintrittsdatum von Mitarbeitern nach deren Geburtsdatum und vor dem aktuellen Tagesdatum sein) oder interne Vorgaben betreffen (Personenkonten in der Finanzbuchhaltung haben 5 Stellen).

Redundanzfreiheit

Redundanz tritt auf, wenn gleiche Informationen mehrfach in einer Informationsquelle vorhanden sind und die betroffene Information ohne Datenverlust an einem der Speicherorte gelöscht werden könnte. Es ist nicht unbedingt erforderlich, dass Duplikate vorliegen. Redundanz besteht bereits dann, wenn beispielsweise Kundenstammdaten wie Kontaktdaten parallel in zwei Systemen gespeichert sind.

Beispiel

Beispiel

Die telefonischen Kontaktdaten des Geschäftsführers der IchRufDichAn GmbH sind sowohl im Datenbestand der Finanzbuchhaltung als auch in der Kontaktdatenbank der Telefonanlage gespeichert. Die Kontaktdaten sind somit im Unternehmen redundant und könnten problemlos in einem der Bestände gelöscht werden.

Beachten Sie aber, dass Redundanz nicht immer negativ ist – manchmal wird sie bewusst herbeigeführt. So wird Ihre IT-Abteilung einen Sicherungsbestand der Unternehmensdaten (hoffentlich) immer zusätzlich an eine externen Ort (z. B. Bankschließfach) aufbewahren. Diese Daten sind redundant, aber bewusst und aus Gründen der IT-Sicherheit (Backup-Strategie).

Relevanz

Um die Anforderung der Relevanz zu erfüllen, müssen Datensätze den entsprechenden Informationsbedarf abdecken. Wenn beispielsweise der Geschäftsführer die Datensätze aller ausländischen Lieferanten benötigt, ist ein enthaltener Datensatz eines italienischen Lieferanten nicht relevant.

Beispiel

Beispiel

Bei der Erstellung von Quartalsberichten sind ausschließlich die Ausgangsrechnungen relevant, deren Ausstellungsdatum innerhalb des betreffenden Quartals liegt. Beim Vergleich verschiedener Berichte desselben Quartals fällt auf, dass sich die Ergebnisse immer wieder unterscheiden. Dies ist darauf zurückzuführen, dass gelegentlich auch Rechnungen einbezogen werden, die für das definierte Quartal nicht relevant sind.

Einheitlichkeit

Das Datenqualitätskriterium Einheitlichkeit wird gewährleistet, wenn artgleiche Werte einheitlich eingegeben werden; dies gilt insbesondere für Texteingaben. Um Fehlinterpretationen und Fehler zu vermeiden, sollten bestimmte Texteingabefelder mit internen Vorgaben versehen sein, um die Einheitlichkeit der Daten sicherzustellen.

Beispiel

Beispiel

Mangels interner Vorgaben zur Eingabe von Städtenamen sind in einem Datenbestand für den Eintrag „München“ folgende uneinheitliche Schreibweisen aufgetaucht:

- München

- Muenchen

- MÜNCHEN

- MUENCHEN

- Munich

- MUNICH

- M Ü N C H E N

Beim Datenfeld „Stadt“ ist daher das Datenqualitätskriterium Einheitlichkeit nicht erfüllt.

Zuverlässigkeit

Die Zuverlässigkeit und Nachvollziehbarkeit der Entstehung von Daten sind unerlässlich, insbesondere in einer Zeit, in der die Bedeutung von Massendaten beispielsweise im Sog der Künstlichen Intelligenz immer weiter steigt. Die Zuverlässigkeit von Datensätzen und deren Entstehung und Verarbeitung stellt ein wichtiges Qualitätsmerkmal dar.

Beispiel

Beispiel

Im Rahmen des Unternehmensreportings wurde festgelegt, dass täglich bis 12:00 Uhr eine definierte Menge an Daten vom Abrechnungssystem an das Buchhaltungssystem übermittelt werden soll. Im Verlauf der Zeit stellte sich jedoch heraus, dass entweder die Datenlieferung verspätet erfolgte oder nur ein Teil der vereinbarten Daten geliefert wurde. Die Zuverlässigkeit der (übermittelten) Daten war nicht gegeben.

Verständlichkeit

Um eine hohe Qualität der Daten zu gewährleisten, ist es wichtig, dass die Informationen gut verständlich sind. Die Datensätze sollten in Bezug auf ihre Struktur, Beschaffenheit und Begrifflichkeit so vorbereitet sein, dass sie von der bearbeitenden Stelle entsprechend interpretiert und verstanden werden können.

Es ist also nicht hilfreich, einem Mitarbeiter in der Buchhaltung eine Tabelle mit unbearbeiteten Spaltenüberschriften aus der ursprünglichen Datenbanktabelle zur Verfügung zu stellen. Ein Programmierer mag gute Gründe haben, das Datenbankfeld „Stadt“ mit „txt_RESIDENCE_40“ zu benennen.

Wenn diese unkommentierte Bezeichnung als Spaltenüberschrift in einer Informations-Tabelle angezeigt wird, ist der Benutzer gezwungen anhand der Werte eine (so gut wie möglich) logische Interpretation über deren Bedeutung vorzunehmen oder bei Unsicherheiten weitere Erläuterungen einzuholen. Verständlich geht in diesem Zusammenhang anders.

Datenqualität messen

Um die Datenqualität zu messen, müssen zunächst klare Kriterien festgelegt werden. Hierbei spielen die bereits erwähnten und erläuterten Datenqualitätskriterien eine Rolle: Vollständigkeit, Aktualität, Genauigkeit und Konsistenz usw.

Um die Datenqualität zu messen, müssen zunächst klare Kriterien festgelegt werden. Hierbei spielen die bereits erwähnten und erläuterten Datenqualitätskriterien eine Rolle: Vollständigkeit, Aktualität, Genauigkeit und Konsistenz usw.

Anhand dieser Kriterien lässt sich dann eine Bewertung vornehmen, um Schwachstellen in den vorhandenen Datenbeständen aufzudecken.

Ein bewährter Ansatz zur Messung der Datenqualität ist die Durchführung von Stichprobenanalysen. Dabei werden repräsentative Teilmengen Ihrer Datensätze ausgewählt und einer gründlichen Prüfung unterzogen. Auf diese Weise lassen sich mögliche Fehlerquellen identifizieren und gezielt beheben.

Beispiel

Beispiel

Das Geburtsdatum natürlicher Personen ist häufig mit dem Wert „01.01.1900“ belegt. Heute kann man davon ausgehen, dass keine Personen leben, die tatsächlich das Geburtsjahr 1900 (über 120 Jahre alt!) haben. Es ist zu prüfen, bei wie vielen Einträgen das Geburtsdatum 01.01.1900 vorkommt (fehlerhafte Daten) und wie hoch der Anteil zu allen Datensätzen ist.

Daten mit „01.01.1900“: 6 Datensätze

Gesamtheit der Daten: 5.967 Datensätze

Somit sind 0,1% der Datensätze fehlerhaft und folglich 99,9% der Datensätze nach diesem Prüfansatz korrekt.

Eine weitere Möglichkeit besteht darin, automatisierte Tools einzusetzen, die kontinuierlich Ihre Daten analysieren und Abweichungen von definierten Qualitätsstandards erkennen können. Diese Tools ermöglichen es Ihnen nicht nur, Fehler schnell zu erkennen und zu korrigieren, sondern auch präventive Maßnahmen zu ergreifen.

Nachfolgend finden Sie eine (alphabetische) Liste mit möglichen Kriterien zur Messung der Datenqualität:

| Aktualität | Allgemeingültigkeit | Alter | Aufbereitungsgrad |

| Änderungshäufigkeit | Bedeutung | Benutzbarkeit | Bestätigungsgrad |

| Betrachtungsweise | Detailliertheit | Effizienz | Eindeutigkeit |

| Flexibilität | Ganzheit | Geltungsdauer | Genauigkeit |

| Glaubwürdigkeit | Handhabbarkeit | Integrität | Klarheit |

| Kompaktheit | Konstanz | Korrektheit | Informationsgrad |

| Neutralität | Objektivität | Operationalität | Performanz |

| Portabilität | Quantifizierbarkeit | Referenzielle Integrität | Relevanz |

| Rechtzeitigkeit | Redundanzfreiheit | Robustheit | Sicherheit |

| Signifikanz | Überprüfbarkeit | Unabhängigkeit | Unität |

| Verlässlichkeit | Verfügbarkeit | Verständlichkeit | Verwendbarkeit |

| Verzerrungsfreiheit | Vollständigkeit | Wahrheitsgehalt | Wiederverwendbarkeit |

| Wirkungsdauer | Zuverlässigkeit | Zugänglichkeit | Zeitbezug |

| Zeitnähe |

Es ist jedoch wichtig anzumerken, dass die Messung der Datenqualität allein nicht ausreicht. Um aussagekräftige Ergebnisse zu erzielen, sollten Sie auch in qualifizierte Mitarbeiter investieren, die sich der Datenqualitätsthematik bewusst sind, über das nötige Fachwissen verfügen und die Datenqualität kontinuierlich überwachen und verbessern können.

Verbesserung der Datenqualität

Ein grundlegendes Prinzip der Informatik kann auch auf die Verbesserung der Datenqualität angewendet werden: „GIGO„, was für „Garbage In — Garbage Out“ (Müll rein — Müll raus) steht. Dies besagt, dass die Ergebnisse nur schlecht sein können, wenn das System mit minderwertigen Eingaben gefüttert wird. Da ein Computer grundsätzlich nicht unterscheiden kann, ob die Eingaben des Benutzers geeignet sind oder nicht, verarbeitet er sie ohne Bewertung und liefert dementsprechend ein ungeeignetes Ergebnis bei minderwertigen Eingaben.

Ein grundlegendes Prinzip der Informatik kann auch auf die Verbesserung der Datenqualität angewendet werden: „GIGO„, was für „Garbage In — Garbage Out“ (Müll rein — Müll raus) steht. Dies besagt, dass die Ergebnisse nur schlecht sein können, wenn das System mit minderwertigen Eingaben gefüttert wird. Da ein Computer grundsätzlich nicht unterscheiden kann, ob die Eingaben des Benutzers geeignet sind oder nicht, verarbeitet er sie ohne Bewertung und liefert dementsprechend ein ungeeignetes Ergebnis bei minderwertigen Eingaben.

Daher sind eine qualitätskonforme Erfassung und Speicherung der Daten entscheidend für deren Qualität. Eine nachträgliche Korrektur ungültiger Dateneingaben erfordert Zeit und Ressourcen. Das GIGO-Prinzip muss daher in den Köpfen aller Anwender implementiert und verankert werden.

Statt „GIGO“ spricht man im Bereich des Datenmanagements auch vom „First Time Right“-Prinzip (von Beginn an korrekt). Allen Mitarbeitern sollte klar sein, dass gute Datenqualität kein einmaliges Projekt ist. Sofortmaßnahmen können zwar schnelle Erfolge bringen, aber darauf auszuruhen ist langfristig keine Lösung. Hohe Datenqualität erfordert einen kontinuierlichen Prozess aus Messen – Analysieren – Korrigieren – Dokumentieren.

Um die strategische Bedeutung zu betonen und ein durchgängiges System im Unternehmen sicherzustellen, empfiehlt es sich, ein Data-Governance-System einzuführen. Data Governance bezeichnet das strukturierte Management von Daten und beinhaltet Vorgaben, Richtlinien und Prozesse zur Sicherung der Qualität sowie des Schutzes und der Sicherheit von Daten.

Fernstudium: Machen Sie Ihren nächsten Karriere-Schritt=> JETZT mit „Betrieblicher Steuerlehre“ beruflich durchstarten!*

Neben den individuellen Unternehmensverfahren zur Optimierung der Datenqualität sollte dieses System auch einen Plan enthalten, wie die anspruchsvollen Anforderungen umgesetzt werden sollen. Es reicht nicht aus, fehlerhafte Daten nur zu identifizieren und darauf hinzuweisen. Stattdessen sollten klare Prozesse definiert sein, wer im Falle einer solchen Situation was tun soll.

Um die Datenqualität zu verbessern ist es ebenfalls wichtig, die Möglichkeiten der IT-Systeme zur Optimierung und Gewährleistung zu kennen. Diese können einfache Programmoptionen wie Pflichtfelder oder komplexe Anpassungen wie Workflows, Freigabeverfahren oder Berechtigungsgruppen umfassen. Falls diese Möglichkeiten unbekannt sind, empfiehlt es sich eine Analyse der vorhandenen On-Board-Mittel durchzuführen und Informationen über deren Anpassungsfähigkeit an individuelle Anforderungen einzuholen.

Abschließend ist hervorzuheben, dass hohe Datenqualität volle Unterstützung seitens des Managements erfordert. Es darf niemals ein isoliertes Projekt der IT-Abteilung oder Finanzbuchhaltung sein, das neben anderen Projekten einfach abgearbeitet wird. Wer immer sich dem Thema Datengüte im Unternehmen annimmt, benötigt die uneingeschränkte Rückendeckung vom ersten Startschuss bis zum regelmäßigen wiederkehrenden Ablaufprozess.

Zusammenfassung

Zusammenfassend lässt sich festhalten, dass Datenqualität ein kritischer Erfolgsfaktor für Unternehmen ist. Sie bildet das Fundament für fundierte Entscheidungen, sichert Vertrauen bei Kunden und Partnern und ermöglicht reibungslose Arbeitsabläufe.

Schlechte Datenqualität birgt hingegen eine Vielzahl von Risiken, von Kundenabwanderung bis hin zu ineffizienten Prozessen und finanziellen Verlusten. Die regelmäßige Überprüfung, Messung und Verbesserung der Datenqualität sollten daher als integraler Bestandteil der Unternehmensstrategie betrachtet werden.

So kann gewährleistet werden, dass die Daten als wertvolle Ressource optimal genutzt werden und einen echten Mehrwert für das Unternehmen darstellen.

Häufige Fragen (FAQ)

Was versteht man unter Datenqualität?

Die Datenqualität beschreibt die Güte und Zuverlässigkeit von Daten für ihren vorgesehenen Verarbeitungs- und Verwendungszweck. Es bezieht sich auf Kriterien wie Genauigkeit, Vollständigkeit, Konsistenz, Aktualität und Relevanz.

Warum ist Datenqualität wichtig?

Daten sind wie ein Vermögenswert für Unternehmen. Je höher ihre Qualität ist, desto wertvoller sind sie für den Geschäftserfolg. Hochwertige Daten bilden die Grundlage für fundierte Entscheidungen und vertrauenswürdige Informationen.

Welche negativen Folgen hat schlechte Datenqualität?

Schlechte Daten können zu Vertrauensverlust bei Kunden und Partnern führen, ineffiziente Arbeitsprozesse verursachen und zu falschen Entscheidungen sowie finanziellen Verlusten führen.

Wie lassen sich Datenqualitätskriterien beurteilen?

Die Bewertung der Datenqualitätskriterien erfolgt anhand von Standards wie Vollständigkeit, Eindeutigkeit, Korrektheit und Aktualität. Häufig werden repräsentative Stichproben analysiert oder automatisierte Tools eingesetzt, um Abweichungen festzustellen.

Wie kann die Datenqualität verbessert werden?

Eine nachhaltige Verbesserung erfordert korrekte und vollständige Dateneingaben von Anfang an. Zudem sind klare Prozesse, Schulungen für Mitarbeiter, die Nutzung von IT-Tools zur Datenvalidierung und die Implementierung eines Data-Governance-Systems essenziell.

Wie kann man Datenqualität effektiv messen?

Die Messung erfolgt durch festgelegte Kriterien und kann mittels Stichprobenanalysen oder automatisierten Tools erfolgen. Wichtig ist, eine ganzheitliche Sicht und ein Prozess, um Fehler zu identifizieren, zu korrigieren und zu dokumentieren.

Wie lassen sich Datenqualitätsprobleme beheben?

Eine systematische Vorgehensweise zur Fehleridentifikation, klar definierte Prozesse zur Fehlerkorrektur und die Nutzung der Möglichkeiten der IT-Systeme sind entscheidend, um Datenqualitätsprobleme zu beheben.

Welche Maßnahmen können Unternehmen ergreifen, um die Datenqualität nachhaltig zu verbessern?

Die Einführung eines Data-Governance-Systems, die Schulung von Mitarbeitern, die Nutzung von IT-Tools zur Überprüfung von Daten und eine klare Unterstützung seitens des Managements sind wirksame Maßnahmen zur nachhaltigen Verbesserung der Datenqualität.